ELK生态中分布式文档存储 ES数据存取原理与支持服务详解

ELK(Elasticsearch, Logstash, Kibana)生态以其强大的日志处理和分析能力著称,而Elasticsearch(ES)作为其核心,提供了高性能的分布式文档存储与检索功能。理解ES如何存储和提取数据,以及其背后的数据处理与存储支持服务,是高效使用该技术栈的关键。

一、Elasticsearch数据存储原理

Elasticsearch本质上是一个基于Lucene的分布式搜索引擎,但其数据模型设计为面向文档的NoSQL存储。

1. 核心概念与数据模型:

文档(Document):存储的基本单元,是一个可被索引的JSON对象,对应数据库中的一行记录。

索引(Index):一类相似文档的集合,是逻辑上的命名空间,对应数据库中的“表”。

类型(Type):在7.x版本后已被弃用,现在一个索引通常只包含一种文档类型。

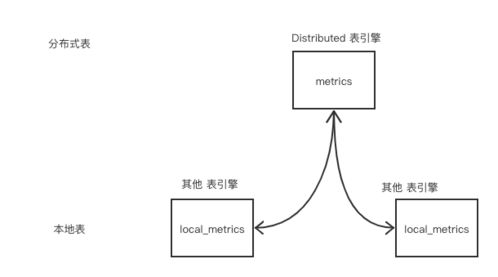

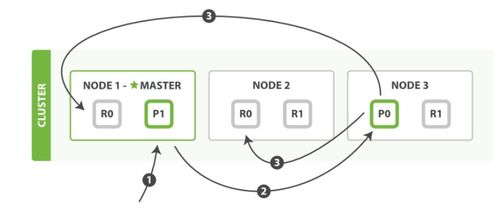

分片(Shard):为实现水平扩展,索引被物理分割成多个分片。每个分片本身是一个功能完整的Lucene索引。分片分为主分片(Primary Shard)和副本分片(Replica Shard)。主分片负责处理写操作,副本分片提供数据冗余和读请求的负载均衡。

* 节点(Node):一个运行的ES实例。多个节点组成一个集群(Cluster)。

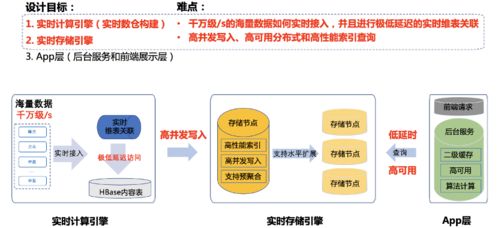

2. 数据写入(存数据)流程:

当一个文档被索引(写入)时,其旅程如下:

- 客户端请求:客户端向集群中任一节点(协调节点)发送写入请求。

- 路由与目标分片:协调节点根据文档ID(或自动生成)通过哈希算法确定该文档应归属于哪个主分片。计算公式通常为:

shard<em>num = hash(</em>routing) % num<em>primary</em>shards。其中<em>routing默认为文档</em>id。这个映射关系在索引创建时确定,之后无法更改主分片数量。 - 转发请求:协调节点将请求转发给该主分片所在的数据节点。

- 主分片处理:数据节点在对应的主分片上执行写入操作。操作首先被写入事务日志(Translog) 以确保持久性,然后被添加到内存缓冲区。

- 刷新(Refresh)与段(Segment)创建:内存缓冲区默认每1秒(可配置)会“刷新”一次,将缓冲区中的数据清空并创建一个新的、不可变的Lucene段(Segment),此时数据才变得可被搜索。这是一个较耗资源的操作。

- 副本同步:写入主分片成功后,请求会被并行转发到所有副本分片。只有所有副本分片也报告成功,协调节点才会向客户端返回成功响应。这保证了数据的一致性。

- 段合并与持久化:后台会定期将多个小的段合并为更大的段以提高效率,并删除已标记删除的文档。Translog会定期刷盘(Flush),将段数据持久化到磁盘,并清空旧的Translog。

3. 数据读取(取数据)流程:

读取分为文档获取(Get by ID)和搜索(Search)。

- 文档获取:这是一个点查询。协调节点同样通过路由算法找到文档所在分片(可以是主分片或副本分片),然后直接向该分片发起请求获取文档。

- 搜索:这是一个更复杂的过程。

- 查询阶段:协调节点将搜索请求广播到索引相关的所有分片(主分片或副本分片)。每个分片在本地执行查询,将匹配文档的文档ID和相关性分数构成一个优先级队列返回给协调节点。

- 取回阶段:协调节点合并所有分片的结果,进行全局排序,筛选出最终需要的文档列表。然后,它再向相关分片发起多文档获取请求,组装完整的文档内容,最终返回给客户端。

二、数据处理与存储支持服务

在ELK生态中,数据的处理与存储并非仅由ES独立完成,而是由一系列服务协同支持。

1. 数据摄入与处理管道:

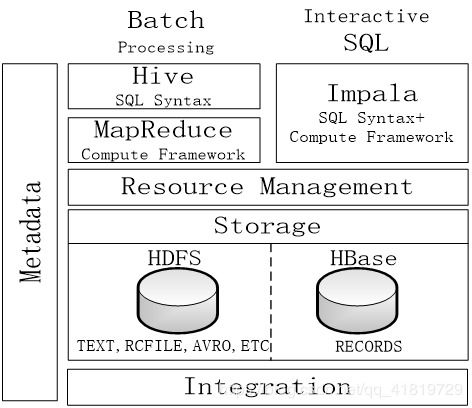

Logstash:作为强大的服务器端数据处理管道,负责从多种来源(文件、Kafka、数据库等)采集数据,通过丰富的过滤器插件进行解析、转换、丰富(如解析JSON、Grok解析日志、字段修改、GeoIP查询等),然后输出到ES或其他目的地。它为ES提供了结构化和标准化的数据源。

Beats:轻量级的数据采集器家族(如Filebeat用于日志文件,Metricbeat用于指标),通常部署在边缘服务器上,将数据直接发送到ES或通过Logstash进行进一步处理。

* Ingest Node:ES自身的摄入节点功能。它允许在文档被索引之前,定义一个预处理管道(Pipeline),对文档执行类似Logstash的转换操作(如重命名字段、设置默认值)。这简化了架构,适用于不需要Logstash复杂功能的场景。

2. 存储与集群管理支持服务:

分布式协调与发现:ES集群使用Zen Discovery或其下一代替代品(如基于Raft的集群协调层) 来自动发现节点、选举主节点、管理集群状态。这是集群高可用和一致性的基础。

索引生命周期管理(ILM):自动化管理索引从“热”(活跃写入和查询)到“温”(只读查询)再到“冷”(很少访问)最后“删除”的整个生命周期。它可以自动滚动创建新索引、迁移分片、调整副本数、删除过期数据,极大简化了运维。

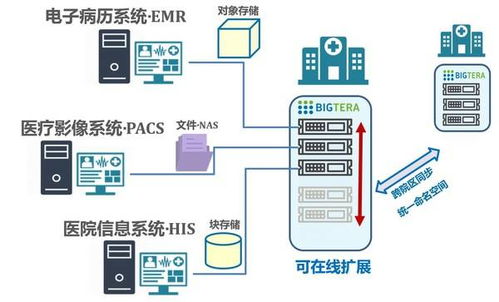

快照与恢复(Snapshot & Restore):使用共享存储库(如S3, HDFS, 文件系统)对整个集群或指定索引创建快照,用于数据备份、迁移或灾难恢复。

监控与管理:ES提供了丰富的API和Kibana的可视化界面,用于监控集群健康、节点状态、索引性能、查询负载等,是运维管理的核心工具。

###

Elasticsearch通过其分片、副本、近实时刷新的机制,实现了海量文档的分布式、高可用、高性能存储与检索。在ELK生态中,Logstash/Beats负责数据的预处理和规范化,而ES内部的Ingest Node、ILM、快照等功能则构成了强大的数据存储与管理支持体系。理解这些原理与服务,有助于我们更好地设计数据管道、优化集群性能、保障数据安全,从而充分发挥ELK栈在大数据搜索与分析领域的强大威力。

如若转载,请注明出处:http://www.opulencespring.com/product/45.html

更新时间:2026-02-25 13:40:27